Mario Ernst analiza los errores estructurales que están llevando a las instituciones financieras a acumular pruebas de concepto, automatizaciones aisladas y poco impacto real con IA. Nos cuenta qué se necesita para pasar de pilotos a transformación real.

La inteligencia artificial llegó a la industria financiera con una velocidad que resultó imposible de prever para la mayoría de las instituciones financieras. Casi por instinto de supervivencia corporativa, los intentos de adopción avanzaron rápidamente en el sector, pero muchas veces sin marcos claros de gobernanza ni planificación estratégica.

Crecieron las implementaciones, pero la integración y transformación real, no tanto.

Para Mario Ernst, CEO y fundador de Evolution Labs, el problema no está en la tecnología sino en cómo se decide adoptarla y capturar valor.

“Está instalada la idea que hay que adoptar IA, pero estamos tomando decisiones erróneas respecto a responsables y recursos, que están creando modelos operativos de innovación que muchas veces no repercuten en el resultado financiero de la organización. Es, de algún modo, una profecía autocumplida para los detractores de la innovación”, enfatiza el especialista.

Al no creer en la iniciativa y avanzar por obligación competitiva, muchas organizaciones no lo están gestionando con el nivel de diseño, gobernanza y disciplina operativa que se requiere.

“Como resultado, la innovación con IA no aporta valor concreto y terminan volviendo a lo tradicional”, expresa Ernst, entrevistado por Abstracta.

Detrás de ese patrón, señala, hay decisiones poco claras sobre liderazgo, metodología y presupuesto para innovar: “muchos directivos culpan a la innovación con IA de no cumplir con la promesa de generar valor, pero no están viendo que en realidad lo que sucede es que no están implementando correctamente”.

La escena se repite en muchos comités ejecutivos: licencias corporativas, equipos probando agentes de forma desordenada, pilotos en áreas distintas y una expectativa implícita de que, por acumulación, “algo va a escalar”.

Sin embargo, cuando diferentes organismos se acercan a Abstracta en su búsqueda de transformación de IA y preguntamos sobre cómo integraron IA, qué procesos críticos del negocio cambiaron o cómo están controlando el nuevo riesgo operativo, la respuesta suele ser difusa.

El punto ciego de la transformación con IA

De a poco, muchas organizaciones comienzan a darse cuenta de que la suma de iniciativas no se convierte en transformación. Para Mario Ernst, el problema central yace en la adopción sin un mapa común de cómo opera el negocio completo.

Su diagnóstico aparece en una frase que convoca a la autocrítica y al análisis profundo: “no hay una mirada de procesos end to end”. Ernst sostiene que, cuando la adopción se vuelve fragmentaria, se pierden dos cosas a la vez: la capacidad de gobernar el riesgo y la capacidad de capturar valor. El resultado es que se avanza pero no necesariamente se construye algo sostenible.

El síntoma: muchos pilotos, poca transformación

En el día a día, esta falta de visión integral se expresa como eficiencia local: cada área mejora su tramo, automatiza tareas, acelera decisiones y, quizás, hasta reduce fricción interna.

El problema se presenta cuando esos tramos no están conectados con el flujo completo de una operación financiera, que suele cruzar negocio, riesgo, compliance, tecnología, operaciones y canales. “Cada área está viendo solo su silo funcional, y eso lleva no solo a la pérdida de visibilidad del proceso, sino también a que los casos de uso no moneticen”.

Cuando esta lógica se instala, el portafolio de iniciativas crece, pero se vuelve difícil responder preguntas básicas como qué procesos críticos están siendo rediseñados de punta a punta, qué controles se están agregando, qué riesgos se están aceptando, y qué impacto económico está probado.

“Tenemos organizaciones llenas de pruebas de concepto (POCs), productos mínimos viables (MVPs) y testeos que carecen de proyectos que realmente están siendo transformacionales y capturando, creando y capturando valor”, subraya el experto.

La causa: adoptar tecnología antes de diseñar el modelo operativo

Ernst observa que muchas instituciones empiezan su adopción de IA disponibilizando herramientas de forma masiva dentro de las empresas, con la esperanza de que la innovación emerja desde el uso.

Para él, esa secuencia genera dos efectos previsibles.

- Iniciativas redundantes o incompatibles entre sí: distintas automatizaciones para el mismo problema, o mejoras locales que crean nueva fricción en otra etapa del flujo.

- Ausencia de criterios compartidos para priorizar casos de uso con impacto transversal.

Mario Ernst en 1era persona,

CEO & Founder en Evolution Labs

¿Por qué existen tantos casos de uso que no llegan a monetizar?

Porque se optimizan tramos aislados y se pierde la mirada del proceso completo que, en la industria financiera, es donde se materializan el control y el valor. Puede haber productividad en una función, pero si el flujo no cambia, el negocio no captura el beneficio en costos, ingresos, conversión o mitigación de riesgo.

¿Por qué crees que tantos pilotos de IA se escalan sin estar realmente listos?

En demasiados casos, cuando se pregunta por qué se escala, no hay sustento cuantitativo: no tienen muchas métricas y avanzan solo porque el proyecto ya se probó o ya se construyó. Se pasa directamente a ejecución, como si fuera un proyecto tradicional. Y ahí está el problema, la primera fase de cada proyecto debería tener siempre el foco en el aprendizaje, no en la monetización.

¿Qué debería tener un proyecto para pasar de piloto a escala?

En primer lugar, tiene que haber una gobernanza clara. Lo segundo es una estrategia que conecte la experimentación con el escalamiento, el llamado “AI Blueprint”, que en el fondo es el plan que permite partir desde casos de uso y POCs pequeñas, para terminar en proyectos escalados que son transversales en la organización. Ahí es donde monetiza.

El riesgo que crece en silencio

Además del retorno, hay una segunda consecuencia que queda subestimada con frecuencia: el riesgo operativo. La IA rediseña procesos, automatiza decisiones y acelera flujos, pero no siempre deja registro claro de qué cambió, qué se delegó a modelos o agentes, y cómo se controla.

Ernst lo describe como un patrón: “no siempre se están identificando los riesgos de esos nuevos procesos tecnológicos y automáticos, y por lo tanto no se están generando los controles adecuados”.

En instituciones reguladas, ese vacío se transforma rápidamente en fricción: auditoría, compliance, disputas internas por responsabilidades y pérdida de visibilidad end-to-end. Y cuando eso ocurre, el impulso inicial de adopción se vuelve defensivo.

La oportunidad: un momento donde “está todo por hacer”

Ernst interpreta el escenario actual como un cambio de época para el sector: de una industria centrada en ejecutar lo establecido a una industria forzada a crear, adaptarse y diferenciarse: “hay mucho espacio para empezar a crear cosas nuevas que no existían y diferenciarse”.

Para quienes lideran innovación, tecnología y operaciones, la oportunidad está en salir de la adopción por acumulación y pasar a una adopción por diseño: procesos completos, prioridades claras, métricas compartidas y gobierno que permita escalar sin perder control.

“Es un momento donde tenemos todo por hacer”, concluyó.

Cómo puede ayudar Abstracta en este escenario

Desde Abstracta, trabajamos con bancos, fintech y organizaciones financieras tanto en etapas tempranas de adopción de IA como en procesos avanzados de transformación.

Fundada en 2008 y con presencia global, Abstracta es una empresa de tecnología que ayuda a las organizaciones a entregar software de alta calidad más rápido, gracias a la combinación de ingeniería de calidad potenciada por IA con experiencia humana.

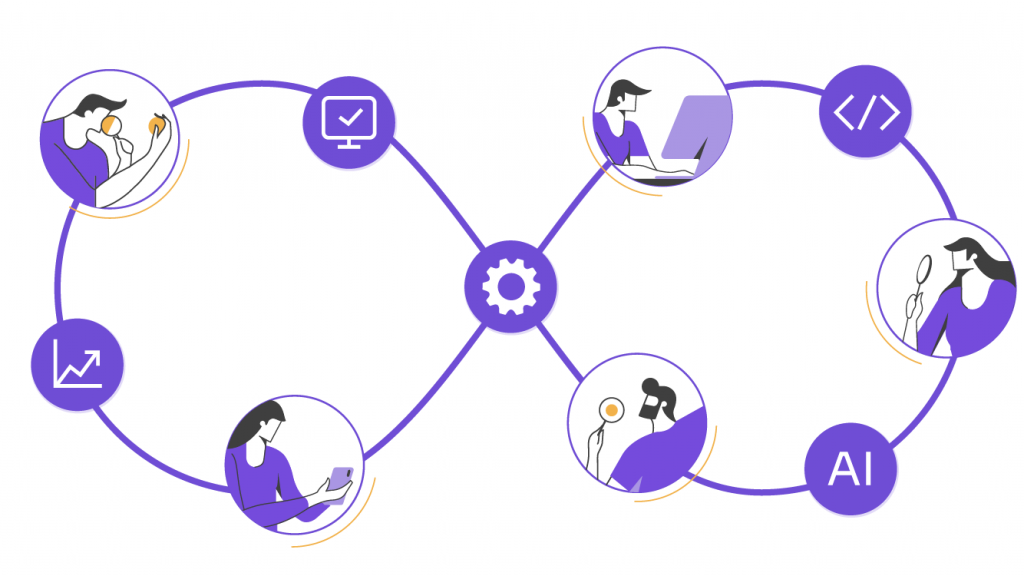

Nuestro enfoque parte de tres ejes:

Visión end-to-end de procesos críticos

Acompañamos tanto a quienes necesitan ordenar y rediseñar flujos ya intervenidos por IA, como a quienes buscan identificar desde cero dónde tiene sentido aplicar inteligencia artificial en procesos completos del negocio.

Comenzamos revisando el proceso actual de delivery de la organización de punta a punta (cómo se construye, prueba, se pasa a producción y se opera el software), para identificar cuellos de botella, brechas de calidad y restricciones estructurales antes de introducir IA.

Gobernanza y despliegue responsable de IA

Ayudamos a definir modelos de gobernanza, criterios de priorización y métricas de madurez para convertir pruebas de concepto en capacidades productivas, o para construir ese camino de forma estructurada desde el inicio.

Como parte de esta base, diseñamos dashboards con KPIs relevantes de ingeniería y entrega (incluyendo métricas DORA) para establecer una línea base clara y medir de forma objetiva el impacto de la adopción de IA en el tiempo.

Ingeniería de calidad, riesgo y seguridad desde el diseño

Integramos testing avanzado, observabilidad, controles y validación continua en iniciativas de IA. Reducimos el riesgo operativo y regulatorio tanto en proyectos existentes como en nuevas implementaciones.

Sobre una estrategia sólida de calidad, identificamos en qué etapas del ciclo de delivery la IA puede generar mayor impacto y definimos cómo medir ese impacto. Complementamos este trabajo con programas de capacitación estructurados para todo el equipo, con foco en construir capacidades internas sostenibles en IA.

Creemos que fortalecer los lazos de forma activa nos permite avanzar y mejorar el software de nuestros clientes. Por eso, a lo largo del tiempo, hemos establecido alianzas con referentes de la industria como Microsoft, Datadog, Tricentis, Perforce BlazeMeter, Sauce Labs y PractiTest

Si estás buscando un partner para el desarrollo de software en finanzas, te invitamos a explorar nuestras soluciones y contactarnos.

¡Síguenos en LinkedIn, X, Facebook, Instagram y YouTube para ser parte de nuestra comunidad!

Recomendado para ti

Checklist de expansión fintech a nuevos países

Cómo modernizar sistemas IBM en banca con IA y sin migraciones

Nuevo producto de Abstracta para conectar agentes AI con sistemas AS400/iSeries

Posts Relacionados

Qué entendemos por “razonamiento” en IA y cómo estabilizarlo

Cómo entender el “razonamiento” en IA, qué implica para riesgo, calidad y ROI, y qué pasos concretos ayudan a estabilizar agentes en tu organización. La palabra “razonamiento” se usa con frecuencia cuando hablamos de Inteligencia Artificial, pero la mayoría de las veces se da por…

¿Cómo probar un agente de IA?

Antes de integrar un agente a un flujo cotidiano de trabajo, es fundamental probar que funcione como esperamos. En este artículo, compartimos 5 grupos de pruebas clave para ejecutar antes de adoptar plenamente un agente. Probar un agente de IA significa evaluar cómo responde en…

Buscar

Categorías

- Automatización de Pruebas

- Calidad de Software

- Cultura

- Desarrollo de Software

- DevOps

- Estrategia

- Eventos

- Fintech

- Herramientas

- Inteligencia Artificial

- Liderazgo

- Partners

- Prensa

- Pruebas de Accesibilidad

- Pruebas de Performance

- Pruebas de Software

- Pruebas en Aplicaciones Móviles

- Tecnología

- Testing Ágil

- Uncategorized