¿Te gustaría entender todo sobre las posibles aplicaciones de la Inteligencia Artificial Generativa? Aprende e impulsa tu negocio de la mano de Abstracta.

¿Qué es la Inteligencia Artificial Generativa (GenAI)? Poder comprender a fondo sus conceptos claves es fundamental no solo para lograr que tu negocio esté a la vanguardia, sino para que mantengas e incrementes tus niveles de competitividad y sostenibilidad.

Las múltiples aplicaciones de la Inteligencia Artificial Generativa nos ofrecen capacidades sin precedentes en procesamiento de lenguaje, imágenes, vídeo y audio naturales, aplicables a todas las industrias y ámbitos del conocimiento.

Ya sea que tengas un rol de líder en una empresa o formes parte de un experimentado equipo de desarrollo y testing, entender los fundamentos de la GenAI y sus aplicaciones puede mejorar significativamente la calidad de tus proyectos y soluciones, así como tu productividad y ROI.

¿Comenzamos?

¡Te invitamos a explorar nuestro servicio personalizado de AI Software Development & Copilots!

¿Qué es la Inteligencia Artificial Generativa? Conceptos clave

La inteligencia artificial generativa es un tipo de IA que tiene la capacidad de crear contenido nuevo y original a partir del análisis de grandes volúmenes de datos. Aprende de datos existentes y genera resultados que no son copias exactas, sino nuevas creaciones inspiradas en esos datos.

El desarrollo de esta tecnología ha avanzado significativamente, impulsado por mejoras en algoritmos y el aumento exponencial de su capacidad de procesamiento. Este avance permite crear soluciones innovadoras, personalizadas y eficientes, que impactan positivamente en múltiples industrias, negocios y áreas del conocimiento.

LLMs, GPT4, OpenAI, Gemini, AI, GenAI y más

Los grandes modelos de lenguaje (LLMs), como GPT-4 y Gemini, son sistemas avanzados de inteligencia artificial diseñados para entender y generar texto, imágenes, vídeo y audio de manera similar a los humanos.

GPT-4, desarrollado por OpenAI, y Gemini, creado por Google, son ejemplos específicos de LLMs que demuestran la capacidad de estas tecnologías para producir resultados que potencian a los humanos en una variedad de aplicaciones.

OpenAI, una organización líder en la investigación de IA, ha sido responsable de crear GPT-4, entre otras tecnologías de IA revolucionarias. Esta organización mantiene una fuerte alianza con Microsoft, lo que le permite avanzar aún más en sus investigaciones y desarrollos en el campo de la inteligencia artificial.

Por otro lado, Google, con su modelo Gemini, también contribuye significativamente al progreso de los LLMs, mediante la colaboración y competencia entre gigantes tecnológicos para impulsar los límites de lo que la IA puede lograr.

La GenAI, o Inteligencia Artificial Generativa, abarca estas y otras diversas tecnologías que simulan procesos de inteligencia humana en máquinas. Este campo amplio y en constante evolución promete transformar radicalmente no solo cómo interactuamos con las máquinas, sino también cómo estas pueden ayudarnos a resolver problemas complejos, innovar en la creación de contenido y mejorar innumerables aspectos de nuestra vida cotidiana y profesional.

Asistentes, copilotos y GPTs

Los copilotos, asistentes y GPTs son herramientas que aprovechan la IA avanzada para mejorar la productividad y eficiencia en los negocios de diferentes maneras.

Asistentes

Son programas impulsados por IA que ayudan a gestionar agendas, manejar comunicaciones, realizar diversas actividades administrativas y buscar información relevante en documentos o páginas web.

Los asistentes no se basan únicamente en el material proporcionado, sino que también puede acceder y procesar información de fuentes externas, como documentos o páginas web, para proporcionar asistencia más completa y contextualizada.

Esto los hace herramientas poderosas para mejorar la productividad y eficiencia en diversos entornos de trabajo.

GPTs

Son versiones personalizadas de ChatGPT, que combinan instrucciones, conocimiento adicional y cualquier combinación de habilidades como interpretación de código, navegación web y APIs externas, para resolver tareas específicas.

Estos GPTs son asistentes de IA especializados para diferentes actividades. No sabemos por qué, OpenAI decidió llamar “Asistentes” a un concepto similar de GPTs, pero con la diferencia de que solo puedes llamar a estos asistentes por API en lugar de usarlos en el frontend de chatGPT.

Los GPTs pueden publicarse en GPTs Store, de OpenAI, y pueden ser compartidos con otras personas que tengan una cuenta y quieran utilizarlos.

Si hacemos un paralelismo con el tiempo presente, podemos preguntarnos si, en el futuro, que una empresa no tenga GPTs configurados para sus necesidades no sea equivalente a carecer de aplicaciones, cuentas en redes sociales o sitios web.

Esto es una analogía poderosa que resalta la creciente relevancia de la inteligencia artificial en el mundo empresarial.

Copilotos

Son sistemas impulsados por IA diseñados para apoyar a profesionales mediante la automatización de tareas y el ofrecimiento de sugerencias para optimizar flujos de trabajo. Si bien comparten capacidades con GPTs y asistentes, presentan una diferencia fundamental: comparten “el contexto” con la persona que ejerce el rol de piloto (es decir, contigo).

¿Qué es exactamente ‘el contexto’? Podría ser cualquier cosa, desde tu pantalla, tu transmisión de audio, tu cámara o cualquier otra información que tú, como piloto, estés recibiendo. Esta información se envía simultáneamente al copiloto.

El copiloto puede acceder a este contexto y, con el acuerdo del piloto, ejecutar acciones dentro de este contexto. Esto permite que el copiloto trabaje en tiempo real codo a codo contigo y te ayude de manera no solo inteligente sino también sumamente eficiente.

Microsoft lidera el desarrollo de copilotos integrando estos copilotos en cada producto.

Bases de datos de vectores e incrustaciones

Las bases de datos de vectores y las incrustaciones son herramientas cruciales para manejar y utilizar datos complejos en los negocios.

Son una forma de representar datos, como texto o imágenes, como vectores numéricos en un espacio de alta dimensión, en busca de capturar la esencia y las relaciones de los puntos de datos.

Por ejemplo, en una reseña de cliente, la incrustación convertiría el texto en un vector que representa el sentimiento y el contexto de la reseña. Las bases de datos de vectores almacenan estas incrustaciones de manera eficiente, y permiten una recuperación rápida, así como búsquedas de similitud y semántica.

Esto significa que las empresas pueden encontrar y analizar rápidamente puntos de datos relacionados, como identificar comentarios de clientes similares o encontrar documentos relevantes, mejorando la toma de decisiones y las experiencias personalizadas de los clientes.

¿Qué son los tokens?

En el contexto de la IA y los LLMs, los tokens son las unidades fundamentales de información (texto e imagen) que el modelo procesa.

Piensa en los tokens como piezas de palabras o caracteres. Por ejemplo, en la oración “La inteligencia artificial está transformando los negocios”, cada palabra podría considerarse un token. Los LLMs como GPT-4 descomponen el texto en estos tokens para entender y generar lenguaje.

El número de tokens afecta el tiempo de procesamiento y el costo del modelo. Más tokens significan más complejidad y computación. Para las empresas, comprender los tokens ayuda a gestionar la eficiencia y el costo de usar modelos de IA para actividades como la generación de contenido, procesamiento e interpretación de datos e interacciones con clientes.

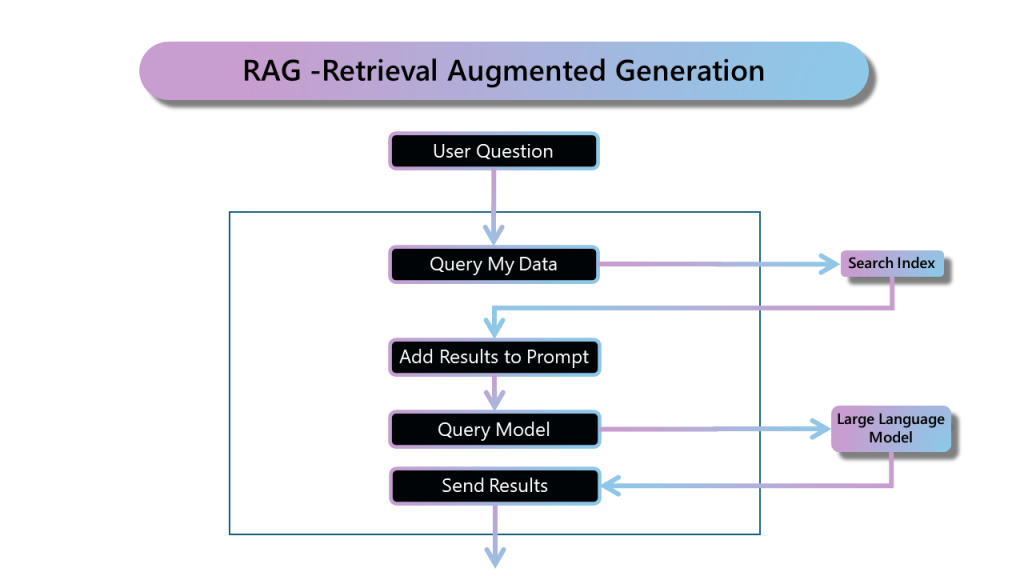

Generación Aumentada por Recuperación (RAG)

El concepto de Generación Aumentada por Recuperación (RAG) es clave en la Inteligencia Artificial Generativa. Se trata de un enfoque innovador que combina técnicas de recuperación de información con modelos de lenguaje generativo (LLMs), como aquellos capaces de entender y generar más de una docena de idiomas, para mejorar la calidad y relevancia del texto generado.

Al acceder a fuentes de conocimiento externas (generalmente almacenadas en bases de datos vectoriales), RAG permite a los modelos producir contenido más preciso, informativo y contextualmente relevante.

RAG opera a través de una serie de pasos, los cuales inicia con la recuperación de información relevante de vastas bases de datos. Esta información se preprocesa e integra en el LLM, para mejorar su comprensión del tema.

¿El resultado? Un modelo generativo que puede acceder a la información más actualizada, fundamentada en conocimientos fácticos, y capaz de generar respuestas con una relevancia contextual y consistencia fáctica sin igual.

Herramientas para tareas específicas

Es importante señalar que no todas las consultas o requisitos pueden resolverse eficazmente utilizando un enfoque LLM universal.

Tal como explica este artículo de LangChaing, con frecuencia es necesario usar herramientas de IA específicas, como por ejemplo en tareas que necesitan datos de otros sistemas o involucran cálculos matemáticos complicados. Esto ayuda a que las aplicaciones de Inteligencia Artificial Generativa sean eficientes y personalizadas, para satisfacer los requisitos únicos de cada proyecto.

El sistema basado en LLM puede responder a una solicitud utilizando herramientas específicas o información RAG para completar la respuesta. Estas herramientas podrían ejecutar tu código existente o conectarse a APIs existentes en tus servicios de backend como CRM o ERP.

¡No te pierdas este artículo! Probando aplicaciones potenciadas con el uso de la Inteligencia Artificial Generativa

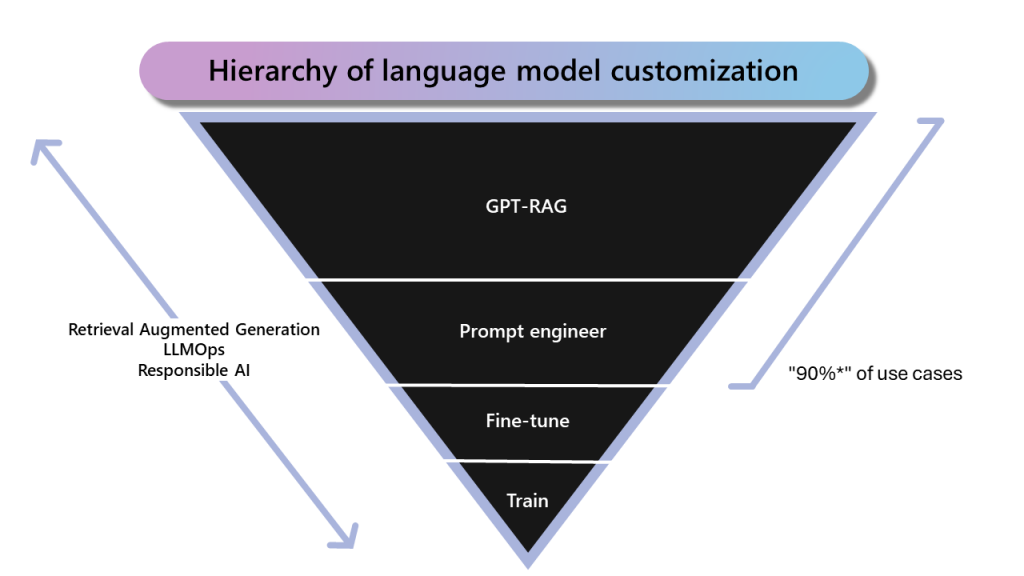

¿Entrenar, ajustar o usar un modelo preentrenado?

La Inteligencia Artificial Generativa ofrece flexibilidad en cómo utilizar los modelos. Las empresas a menudo enfrentan la decisión de si entrenar sus propios modelos, aprovechar los modelos preentrenados existentes, o simplemente ajustar un modelo preentrenado.

Esta elección depende de varios factores, como los requisitos específicos del caso de uso, la disponibilidad de datos y los recursos disponibles.

En nuestra experiencia, y según la información de Microsoft, el 90% de los casos de uso pueden resolverse con RAG y la ingeniería de solicitudes.

Esto es una buena noticia, ya que el ajuste fino requiere muchos datos y el proceso de entrenamiento no solo exige datos de calidad sino que también consume recursos de hardware significativos, como la capacidad de GPU.

Al considerar si entrenar modelos específicos desde cero o ajustar un modelo existente, es importante comprender que existen distintos escenarios que podrían llevar a diferentes recomendaciones.

Compartimos cómo tus escenarios pueden alinearse con estos enfoques:

Requisitos de baja latencia

Ajustar un modelo:

Con frecuencia, recomendamos ajustar debido a que solo ajusta las capas finales. En computación, esto puede ser más rápido y menos intensivo.

Recomendaciones para “modelos pequeños”

- Entrenar modelos específicos:

Si la tarea es estrecha y bien definida, podría ser mejor comenzar desde cero. Puedes diseñar la arquitectura, con el fin de lograr que sea compacta. - Ajustar un modelo:

Alternativamente, ajustar un pequeño modelo preentrenado para tus necesidades también puede ser una buena opción. La elección depende de las restricciones del proyecto.

Reducir los requisitos de hardware

- Ajustar un modelo:

Comenzar con un modelo preentrenado generalmente requiere menos computación, por lo cual generalmente es más eficiente en términos de hardware. - Entrenar modelos específicos:

Si la tarea es altamente especializada, sugerimos considerar la posibilidad de diseñar un modelo eficiente, lo cual implica una planificación cuidadosa.

En resumen, la elección entre entrenar modelos específicos desde cero y ajustar un modelo existente depende de los requisitos específicos del proyecto, en consideración de la latencia, el tamaño del modelo y las restricciones de hardware.

Algo que nos gustaría destacar es que cuando entrenamos o ajustamos un modelo, los datos utilizados en este proceso se incorporan al modelo y no podemos controlar quién puede acceder a estos datos. Todas las personas que usan estos modelos podrían acceder a estos datos.

Modelos de código abierto vs. propietarios

En Inteligencia Artificial Generativa, existen tanto por modelos de código abierto (también llamados open-source) como propietarios.

Los modelos de código abierto, tales como Llama3, Vicuña y Alpaca, nos permiten ejecutar estos modelos en nuestra propia infraestructura. Por su lado, los modelos propietarios, como GPT4, GPT4o, Claude y Gemini, solo están disponibles en los proveedores de nubes como Azure y OpenAI.

Ejecutar los modelos en nuestra propia infraestructura podría reducir el costo (en algunos escenarios con uso intensivo de los modelos) y darnos más control sobre los datos sensibles.

Elegir entre estas opciones implica considerar los requisitos de seguridad del proyecto, el presupuesto y el nivel deseado de personalización.

Costos: gestionando el presupuesto

Cuando fomentamos una nueva iniciativa de LLM, necesitamos entender los costos relativos asociados con este tipo de sistema. Tenemos costos similares con respecto a los equipos que desarrollan y mantienen el sistema, y también necesitamos contemplar los costos asociados con el uso de los LLMs.

Si bien este costo específico seguirá disminuyendo, necesitamos tener seguridad sobre el ROI del nuevo sistema de IA.

El costo del Modelo de Lenguaje Grande depende de cuántos tokens estamos usando, el modelo de LLM que estamos empleando, el proveedor del modelo y si estamos hospedando el modelo en nuestra infraestructura (modelo de código abierto).

Por esta razón, una característica importante que todos los sistemas de LLM tienen que implementar es la observabilidad del uso y los costos de cada modelo.

A continuación, compartimos algunas características importantes para controlar el presupuesto en tu proyecto con LLMs son:

- Limitar el presupuesto para cada usuario

- Almacenar consultas y resultados en caché

- Evaluar si puedes usar un modelo reducido para las tareas específicas

- Evaluar el costo y los beneficios de hospedar un modelo de código abierto en tu infraestructura

Si manejar temas de privacidad y presupuesto son importantes para tu negocio, te invitamos a explorar PrivateGPT, una solución que hemos desarrollado en Abstracta que te permite acceder a diferentes LLMs de manera segura y control de presupuesto.

Manejo de datos, para incrementar los niveles de seguridad

En el ámbito de la GenAI, la seguridad y privacidad de los datos son primordiales.

Por ello, es esencial saber que podemos usar LLMs a través de APIs ofrecidas por Azure, que pone a disposición los nuevos modelos de OpenAI muy rápido, Google o Amazon. En estos escenarios, tendremos control de nuestros datos en este proveedor de nube.

Todos estos proveedores tienen todos los estándares de seguridad y certificaciones.

Si esto no es una opción para tu proyecto, ya que por ejemplo no puedes enviar información fuera del país o tu propia infraestructura, entonces podríamos usar modelo de código abierto. En el caso de estos escenarios, tienes control total de tus datos.

Otra consideración importante es que, cuando entrenamos un modelo, los datos que se usaron en el entrenamiento pueden accederse más tarde por cualquiera. Esto implica que no podemos definir “permisos” para cada rol y persona en la organización.

Por eso, en la mayoría de los casos, la técnica RAG es la mejor opción, debido a que nos brinda un control total sobre quién accede a qué información.

Explora nuestras soluciones de seguridad para mejorar la fiabilidad general de tu sistema.

Desarrollando sistemas basados en LLMs

¿Qué es Langchain?

Langchain representa un marco de trabajo de código abierto de vanguardia, diseñado para construir aplicaciones impulsadas por LLMs. Simplifica el proceso de desarrollo, y permite a los equipos de desarrollo crear aplicaciones conscientes del contexto, que aprovechan los datos y las APIs de la empresa.

No solo facilita la construcción y despliegue de aplicaciones de IA, sino que también proporciona herramientas para monitorear y mejorar su rendimiento. Esto ayuda a crear soluciones de alta calidad y más confiables.

Microsoft Copilot Studio

Microsoft Copilot Studio ha introducido una nueva era de copilotos de IA personalizados. Ha posibilitado la personalización de las experiencias de Microsoft 365 y la creación de aplicaciones copiloto únicas. Aprovecha las tecnologías centrales de los modelos de conversación de IA para transformar las experiencias de las personas.

Con Copilot Studio, los equipos de desarrollo pueden diseñar, construir y desplegar copilotos de IA que atiendan a escenarios específicos, todo esto mientras mejoran su eficiencia.

GeneXus Enterprise AI

GeneXus Enterprise AI ofrece una solución única para empresas que buscan aprovechar el poder de los LLMs de manera segura, monitoreada y rentable. Potencia la creación de asistentes de IA que pueden integrarse sin problemas con las operaciones existentes, para mejorar sus niveles de productividad e innovación.

Al enfocarse en la privacidad de datos y optimizar el gasto en IA, GeneXus permite resolver problemas complejos usando lenguaje natural y logrande que la IA avanzada sea más accesible que nunca antes.

Abstracta Copilot

Abstracta Copilot es una herramienta potenciada con Inteligencia Artificial para mejorar las pruebas de software, desarrollada por Abstracta en colaboración con el Co-Innovation Lab de Microsoft. Lanzada en octubre de 2024 en la Quality Sense Conf 2024, la herramienta utiliza IA para optimizar las pruebas de software y la documentación, aumentar la eficiencia y mejorar la productividad hasta en un 30%, y reducir los costos en un 25%.

- Acceso a la base de conocimientos: Accede rápidamente a información relevante de los productos y también contextual. Busca semánticamente a través de 16 años de experiencia en más de 1,000 proyectos y nuestros libros publicados, y recupera conocimientos completos y accionables con eficiencia.

- Asistencia impulsada por IA: Ofrece orientación en tiempo real para el desarrollo y testing de aplicaciones. Permite que los equipos de testing y análisis interactúen de forma directa con los sistemas con lenguaje natural.

- Análisis de negocio: Interpreta rápidamente los requisitos funcionales y genera historias de usuario.

- Generación de casos de prueba: Produce casos de prueba manuales y automatizados a partir de historias de usuario, con foco en maximizar la cobertura desde la perspectiva del usuario final.

- Monitoreo de rendimiento y seguridad: Identifica problemas durante las pruebas manuales en tiempo real, lo cual permite que los equipos respondan más rápido.

- Integración sin problemas: Funciona dentro del sistema bajo prueba.

- Flujos de trabajo personalizados: Hechos a la medida para las necesidades organizacionales específicas, lo que permite una mayor personalización y productividad.

En asociación con Microsoft, en Abstracta podemos ayudarte a crear e implementar soluciones personalizadas para tus aplicaciones empresariales. Te invitamos a conocer nuestro caso de éxito de Bantotal.

Browser Copilot

Desarrollado por nuestro equipo de innovación en Abstracta, Browser Copilot es un copiloto revolucionario y de código abierto que integra asistentes de IA en tu navegador. Admite una amplia gama de aplicaciones, desde SAP hasta Salesforce, y proporciona asistencia personalizada en diversas aplicaciones web.

Browser Copilot ofrece automatización contextual e interoperabilidad, lo cual lo convierte en una herramienta invaluable para múltiples cometidos.

Preguntas frecuentes

¿Por qué es importante la Inteligencia Artificial Generativa?

La Inteligencia Artificial Generativa es importante porque tiene la capacidad de crear contenido nuevo y original, como texto, imágenes, música y más, a partir de datos existentes. Esto abre posibilidades ilimitadas para la innovación en diversas industrias y áreas del conocimiento.

Su capacidad para entender y generar lenguaje natural revoluciona la interacción entre el ser humano y las máquinas y abre infinitas posibilidades, antes solo reservadas para la ciencia ficción.

La IA generativa permite automatizar tareas repetitivas o complejas. Existen múltiples ejemplos de ello, tales como la gestión de correo electrónico, la creación de código con fines de desarrollo y la generación de contenidos personalizados para todo tipo de público y cualquier plataforma existente. En definitiva, puede ayudar a resolver problemas complejos, proporcionar nuevas perspectivas y fomentar la innovación, lo que la convierte en una herramienta valiosa para el avance tecnológico y económico.

¿Cuáles son las aplicaciones principales de la inteligencia artificial?

Las aplicaciones principales de la IA incluyen la automatización de procesos mediante software de vanguardia y robots no físicos, que pueden realizar desde tareas administrativas hasta análisis complejos de datos.

- Automatización de procesos robóticos (RPA): automatización de tareas repetitivas en diversos sectores.

- Análisis de datos y predicción: uso de algoritmos de machine learning para analizar grandes volúmenes de datos y predecir tendencias.

- Reconocimiento de voz y procesamiento de lenguaje natural (NLP): desde asistentes virtuales hasta sistemas de traducción automática.

- Visión por computadora: aplicaciones en seguridad, salud, y retail, entre otros, para el reconocimiento de imágenes y patrones.

- Vehículos autónomos: desarrollo de sistemas de conducción autónoma en la industria automotriz.

- Personalización en el comercio electrónico y marketing digital: recomendaciones personalizadas basadas en el comportamiento del usuario.

¿Cuáles son las IA actuales?

Las IA actuales se pueden clasificar en varios tipos, según su complejidad y aplicación:

- IA débil o estrecha (ANI): Sistemas diseñados y entrenados para realizar tareas específicas, como reconocimiento de voz o recomendaciones de productos.

- IA general (AGI): Aunque aún es un objetivo a largo plazo, la AGI se refiere a sistemas de IA con capacidades cognitivas humanas, capaces de aprender y aplicar conocimientos en una amplia gama de tareas.

- IA superinteligente: Un concepto teórico que se refiere a una inteligencia artificial que supera ampliamente la inteligencia humana en todos los aspectos, desde la creatividad hasta la toma de decisiones.

En el panorama actual, la mayoría de las aplicaciones de IA pertenecen a la categoría de IA débil o estrecha, especializadas en tareas concretas y operando bajo un conjunto limitado de parámetros y contextos.

Cómo podemos ayudarte

Con más de 16 años de experiencia y presencia global, Abstracta es una empresa líder en soluciones tecnológicas, especializada enservicios de pruebas de software y desarrollo de software impulsado por IA.

En Abstracta, creamos una alianza con Microsoft para impulsar la innovación y mejorar nuestras soluciones con tecnología de IA de vanguardia aplicada al desarrollo y prueba de software.

Explora nuestro servicio de desarrollo de software de IA para empoderar a tu organización e incrementar tanto tus niveles de productividad como de calidad. Contáctanos para discutir cómo podemos ayudarte a hacer crecer tu negocio.

Síguenos en LinkedIn, X, Facebook, Instagram y YouTube para ser parte de nuestra comunidad!

Recomendado para ti

Cómo utilizar la IA Generativa para potenciar tu empresa

Probando aplicaciones potenciadas con el uso de la Inteligencia Artificial Generativa

Nuevo Chatbot de IA: Cómo construimos nuestro propio ChatGPT para experimentar más rápido

Etiquetas

Posts Relacionados

Ética en la inteligencia artificial: Guía estratégica empresarial

¿Cómo aplicar la inteligencia artificial en tu empresa de forma ética? Creamos una guía práctica para integrar IA de forma segura, transparente y alineada con tu estrategia de negocios. Un solo sesgo en un modelo de IA puede costarle a una empresa demandas millonarias, pérdida…

Abstracta Copilot: La revolución en pruebas de software con IA

Abstracta Copilot es una herramienta potenciada con Inteligencia Artificial para mejorar las pruebas de software, desarrollada por Abstracta en colaboración con el Co-Innovation Lab de Microsoft. Utiliza IA para optimizar las pruebas de software y la documentación, aumentar la eficiencia y mejorar la productividad hasta…

Buscar

Categorías

- Automatización de Pruebas

- Calidad de Software

- Cultura

- Desarrollo de Software

- DevOps

- Estrategia

- Eventos

- Fintech

- Herramientas

- Inteligencia Artificial

- Liderazgo

- Partners

- Prensa

- Pruebas de Accesibilidad

- Pruebas de Performance

- Pruebas de Software

- Pruebas en Aplicaciones Móviles

- Tecnología

- Testing Ágil

- Uncategorized